- De opkomst van de AI-gestuurde psycholoog

- Hebben patiënten echt iets aan AI-gestuurde cognitieve gedragstherapie?

- AI-therapeuten als oplossing voor de extreem lange wachtlijsten

- Even voorstellen: de nieuwe generatie AI-therapie apps

- Wat zijn de risico’s als we onze mentale gezondheid overlaten aan AI?

- Het gebruik van AI in de geestelijke gezondheidszorg leidt ook tot verontrustende incidenten

- Hoe gaan we om met de uitdagingen van AI-therapeuten?

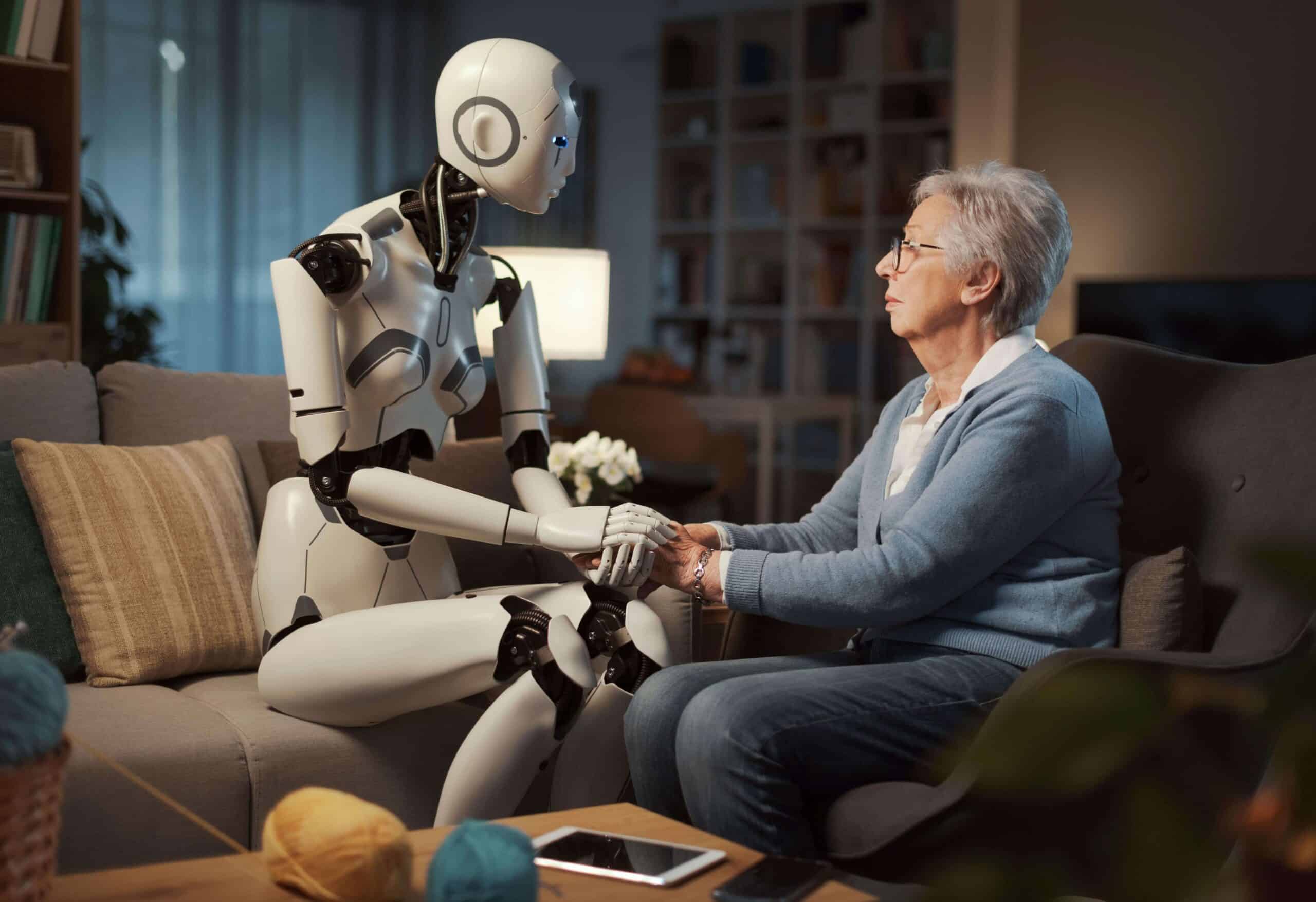

In de niet al te verre toekomst zou de manier waarop we onze geestelijke gezondheid managen wel eens compleet kunnen veranderen, dankzij de snelle ontwikkelingen op het gebied van kunstmatige intelligentie (AI). De kans is groot dat we binnenkort niet meer alleen vertrouwen op menselijke therapeuten om ons door onze emotionele uitdagingen heen te helpen. In plaats daarvan krijgen we steeds meer te maken met slimme algoritmes die de rol van onze empathische vertrouwenspersonen overnemen. Het idee van een ‘AI-therapeut’ spreekt natuurlijk enorm tot de verbeelding. Deze technologie is ontwikkeld om aandachtig naar onze diepste angsten en zorgen te luisteren en ons te helpen — door middel van gepersonaliseerd advies — deze problemen aan te pakken. Omdat deze AI-systemen enorme hoeveelheden data kunnen analyseren, zijn ze misschien zelfs veel effectiever dan hun menselijke collega’s. Zo kunnen ze de kernoorzaken van onze mentale problemen veel sneller vaststellen en op maat gemaakte behandelplannen aanbieden.

In dit artikel duiken we dieper in de nieuwste ontwikkelingen op het gebied van kunstmatig intelligente therapietools. We bekijken de mogelijke voordelen van AI-gestuurde cognitieve gedragstherapie (CGT) en onderzoeken of machines echt beter zijn in het diagnosticeren van mentale gezondheidsproblemen. Ook laten we je verschillende voorbeelden zien van hoe deze baanbrekende technologie al bij verschillende soorten therapieën wordt toegepast. Natuurlijk staan we ook stil bij de uitdagingen, de inherente ethische aspecten en de privacy-implicaties — belangrijke zaken om rekening mee te houden nu het eruitziet dat we onze meest intieme gedachten en gevoelens straks steeds vaker aan een algoritme gaan toevertrouwen.

“In geen enkel ander medisch gebied kunnen chatbots zoveel verschil maken als in de geestelijke gezondheidszorg”.

Thomas Insel, voormalig directeur National Institute of Mental Health

De opkomst van de AI-gestuurde psycholoog

Daar waar technologie en geestelijke gezondheidszorg samenkomen, vindt een boeiende ontwikkeling plaats: de opkomst van de AI-therapeut — een concept dat de afgelopen jaren langzaam gestalte heeft gekregen. In de vroege jaren ’90 waren er al computerprogramma’s die psychologische ondersteuning boden, voornamelijk in de vorm van cognitieve gedragstherapie via digitale platforms. De laatste tijd heeft dit concept zich echter ontwikkeld tot iets dat veel verfijnder en interactiever is. De nieuwste geestelijke gezondheidsapps, zoals bijvoorbeeld Wysa en Woebot Health, maken gebruik van geavanceerde AI-algoritmen, waardoor je er betekenisvolle gesprekken mee kunt voeren. Deze slimme systemen analyseren grote hoeveelheden gebruikersgegevens, herkennen patronen en bieden op maat gemaakte adviezen. Experts op het gebied van geestelijke gezondheid geloven dat deze tools in bepaalde opzichten zelfs effectiever kunnen zijn dan menselijke therapeuten. Maar het gebruik van AI beperkt zich niet tot zelfhulp-apps. Organisaties als de Britse National Health Service (NHS) maken bijvoorbeeld al gebruik van chatbots om standaardvragenlijsten af te nemen en te ondersteunen bij diagnoses.

Vooraanstaande figuren in de gezondheidszorg, zoals Thomas Insel van Vanna Health, zien enorm veel mogelijkheden in de toepassing van large language models als Google’s Bard en OpenAI’s ChatGPT. Insel benadrukt: “In geen enkel ander medisch gebied kunnen chatbots zoveel verschil maken als in de geestelijke gezondheidszorg”. Door AI routinematige taken te laten automatiseren — zoals het samenvatten van sessies en het schrijven van rapporten — kunnen zorgverleners meer tijd besteden aan directe, persoonlijke behandeling en ondersteuning. Insel schat dat deze AI-ondersteuning de productiviteit van professionals in de geestelijke gezondheidszorg met wel 40 procent kan verhogen — een belangrijke ontwikkeling gezien de huidige tekorten in de sector. Door de explosieve toename in het aanbod van apps voor mentale gezondheid en therapie, waarvan sommige zelfs meer dan een miljoen keer zijn gedownload, blijkt duidelijk dat AI-ondersteuning in de toekomst een steeds grotere rol zal innemen in de manier waarop we omgaan met geestelijk welzijn.

“Met AI heb ik het gevoel dat ik in een echte ‘no-judgmentzone’ praat. Uiteindelijk maakt het helemaal niet uit of je nu met een levend persoon of met een computer te maken hebt. Zolang ik maar de hulp krijg op een manier die voor mij werkt”.

Melissa, onderzoeksdeelnemer

Hebben patiënten echt iets aan AI-gestuurde cognitieve gedragstherapie?

Stel je voor: therapie die helemaal voor jou op maat gemaakt is en gebaseerd op de kennis van duizenden experts. Dit klinkt misschien futuristisch, AI als je persoonlijke therapeut, maar dit wordt sneller werkelijkheid dan je misschien denkt, vooral binnen de cognitieve gedragstherapie. Met de hulp van AI gaan we een toekomst tegemoet waarin therapie niet alleen persoonlijker en effectiever is, maar ook gemakkelijker toegankelijk en betaalbaarder dan ooit. Deze transformatie wordt mogelijk gemaakt door slimme algoritmes die een diepe duik nemen in uitgebreide klinische data, zoals de geschiedenis en persoonlijke verhalen van patiënten en transcripties van therapiesessies, maar ook de nieuwste ontwikkelingen in de neurowetenschap en psychologie. Hierdoor zijn we niet meer alleen afhankelijk van de ervaringen van één therapeut, maar kunnen we putten uit enorme uitgebreide wereldwijde kennis. Dit betekent dat er aan de ‘one-size-fits-all’-benadering langzaam maar zeker een eind komt, want de digitale therapeuten van morgen passen hun methoden en stijl aan jouw unieke situatie aan.

Maar AI kan op het gebied van therapie meer bieden dan alleen personalisatie. Het helpt bij het sneller en nauwkeuriger stellen van diagnoses, door alles — van je medische geschiedenis tot subtiele signalen zoals je gezichtsuitdrukkingen — te analyseren. Dit kan therapeuten helpen om in sommige gevallen zelfs beter te presteren dan de meest doorgewinterde experts. En omdat deze AI-therapeuten geen last hebben van een overvolle agenda, zijn ze beschikbaar wanneer jij ze nodig hebt. Dit zorgt voor een continue en intensieve zorg die sneller tot resultaten kan leiden, iets wat met traditionele therapie soms langer op zich laat wachten. AI-therapie biedt ook wat kosten betreft enorme voordelen. Traditionele face-to-face-sessies zijn vaak behoorlijk prijzig en worden niet in alle gevallen — of maar deels — door zorgverzekeringen vergoed. AI-gestuurde psychologische support is wat dat betreft dus ook een aantrekkelijk alternatief, waardoor kwalitatief goede geestelijke gezondheidszorg voor een veel breder publiek toegankelijk wordt. Bovendien geeft de anonimiteit van een AI-therapeut vooral voor jongeren en mensen uit gemarginaliseerde groepen een ‘veilig’ gevoel, waardoor ze makkelijker over hun problemen praten. Op deze manier kan één van de grootste drempels voor effectieve therapie — de angst om zich helemaal open te stellen — weggenomen worden. Uit onderzoek blijkt bijvoorbeeld dat meer dan 90 procent van de mensen die in therapie zijn, toegeeft wel eens niet de waarheid te hebben verteld. Bijvoorbeeld over zaken als drugsgebruik, zelfbeschadiging of zelfdoding.

Ross Harper, de CEO van AI-startup Limbic, zegt dat het chatbotsysteem van zijn bedrijf vooral een belangrijke rol speelt bij het betrekken van gemeenschappen die vaak minder makkelijk toegang hebben tot hulp. “Het zijn vooral de minderheidsgroepen die doorgaans lastig te bereiken zijn, die veel baat hebben bij ons systeem”, vertelt hij. “Onze AI wordt gezien als fundamenteel niet-oordelend”. Volgens een recente studie, mede geschreven door Harper en gepubliceerd in het gerenommeerde wetenschappelijke tijdschrift Nature Medicine, zorgde Limbic’s AI-triagesysteem ervoor dat 29 procent meer mensen uit etnische minderheidsgroepen werden doorverwezen naar de NHS voor persoonlijke behandeling van geestelijke gezondheidsproblemen. Hoewel de technologie nog in de kinderschoenen staat, kan de anonimiteit en het ontbreken van vooroordelen mensen aanmoedigen om opener te zijn over problemen waar ze mee worstelen.

Een recent onderzoek naar gebruikerservaringen met de CBT-chatbot Wysa onthulde iets interessants over de ‘sociale relaties’ die patiënten met AI-systemen ontwikkelen. Zo ontdekten onderzoekers van de Stony Brook University en het National Institute of Mental Health in India dat deelnemers al snel een haast authentieke ’therapeutische alliantie’ met de chatbot ontwikkelden. Ze gaven aan zich dankbaar te voelen — en lieten dit ook blijken — en waren ervan overtuigd dat de bot oprecht om hen gaf. Deze ‘verbondenheid’ is bijzonder opmerkelijk, vooral als je bedenkt dat de bot anonimiteit biedt en niet oordeelt. Een van de gebruikers, Melissa, legt uit dat ze zich bij de chatbot emotioneel kwetsbaar durfde op te stellen, iets dat ze bij een menselijke therapeut moeilijk vindt. “Met AI heb ik het gevoel dat ik in een echte ‘no-judgmentzone’ praat. Uiteindelijk maakt het helemaal niet uit of je met een levend persoon of met een computer te maken hebt. Zolang ik maar de hulp krijg op een manier die voor mij werkt”.

Dr. Angela Skrzynski, een huisarts in New Jersey, merkt dat haar patiënten er over het algemeen wel voor openstaan om AI-chatbots te proberen als ze lang op een afspraak met een therapeut moeten wachten. Haar werkgever, de non-profit academische zorgverlener Virtua Health, biedt sommige volwassen patiënten bijvoorbeeld het platform Woebot aan. Opvallend is dat Woebot geen gebruikmaakt van generatieve AI-modellen, omdat oprichter Alison Darcy van mening is dat deze uitdagingen opleveren in de gezondheidszorg. “We konden niet voorkomen dat de large language models (LLMs) mensen vertelden hoe ze moesten denken, in plaats van hun eigen proces te faciliteren”, legt Darcy uit. In plaats daarvan gebruikt Woebot duizenden gestructureerde taalmodellen die door het eigen personeel en onderzoekers zijn ontwikkeld — een op regels gebaseerde aanpak die volgens Darcy veiliger en geschikter is voor therapeutische toepassingen. Woebot biedt apps voor verschillende doelgroepen, van jongeren tot mensen met verslavingsproblematiek. Uit een studie in het Journal of Medical Internet Research blijkt dat symptomen van depressie dankzij het platform al binnen twee weken aanmerkelijk afnemen. De bot zou dan ook een goede, toegankelijke aanvulling kunnen zijn op reguliere therapie.

Even voorstellen: de nieuwe generatie AI-therapie apps

Er is een nieuwe generatie slimme apps voor de geestelijke gezondheid die de manier waarop we psychologische ondersteuning krijgen compleet verandert. Deze AI-gestuurde tools bieden persoonlijke begeleiding en zijn beschikbaar in de vorm van bijvoorbeeld slimme chatbots of immersieve virtuele therapiesessies. Door AI-oplossingen met traditionele therapie te combineren wordt de geestelijke gezondheidszorg voor meer mensen toegankelijk en kan er meer holistische hulp geboden worden. Hoewel sommige van deze apps in Nederland nog niet beschikbaar zijn, is de verwachting dat deze binnenkort ook hier geïntroduceerd zullen worden.

Tomo

Neem bijvoorbeeld Tomo, een wellness- en meditatie-app ontwikkeld door AI-bedrijf Replika en het team achter de AI-datingsimulator Blush. Tomo neemt je mee naar een virtueel eilandresort, waar je door een AI-avatar, ook Tomo genaamd, wordt begeleid. De app biedt allerlei programma’s voor persoonlijke groei, mentaal welzijn en zingeving. Denk bijvoorbeeld aan begeleide meditatie, yoga, motiverende affirmaties en virtuele gesprekssessies. Eugenia Kuyda, CEO van Replika, vertelt: “We hebben de programma’s voor Tomo samen met coaches en psychologen samengesteld. Daarbij hebben we gekeken naar de meest voorkomende problemen, maar ook naar wat met slimme gesprekstechnologie goed zou werken”. Ze gebruikten hun eerdere ervaringen met het ontwikkelen van coachingtools als basis voor Replika, in samenwerking met klinische experts van UC Berkeley. Het doel was een mix van Oosterse en Westerse methodes te creëren die goed met conversatie-AI gecombineerd kunnen worden.

Together by Renee

Een andere innovatieve oplossing is ‘Together by Renee’, een health assistant die spraakherkenningstechnologie gebruikt om symptomen van angst en depressie op te sporen. De app is ontwikkeld door dr. Renee Dua, oprichter van de telemedicine-aanbieder Heal. De ‘mental vitals’-feature van de tool analyseert je stem, en op basis van factoren als melodie, bewegingen van het strottenhoofd en stembandendynamiek kan het tekenen van mentale gezondheidsproblemen herkennen. Dua legt uit dat de tool zulke signalen al in een paar seconden kan oppikken, waardoor je veel sneller hulp en begeleiding kunt krijgen dan met een traditionele diagnose bij de dokter.

Brain

Met hulp van een team expert-psychologen hebben geestelijke gezondheidsorganisatie Thera4all en IT-bedrijf Plain Concepts ‘Brain’ ontwikkeld: een innovatief platform dat zeer immersieve AI-therapie-ervaringen mogelijk maakt. Brain gebruikt geavanceerde grafische technologie om een verbazingwekkend realistische virtuele therapeut te creëren. Het uiterlijk en de gezichtsuitdrukkingen zijn naadloos gesynchroniseerd met hoe de ‘therapeut’ spreekt. De geavanceerde systemen ‘onder de motorkap’ zorgen ervoor dat de virtuele therapeut betrouwbaar en deskundig advies geeft, zonder ongepaste suggesties te doen. Hierbij wordt uiteraard zeer zorgvuldig met privacy en databeveiliging omgegaan.

Pi

Conversationele AI-assistenten, zoals ‘Pi’ van Inflection AI, doen langzaam maar zeker ook hun intrede in de geestelijke gezondheidszorg. Pi is ontworpen als een slimme persoonlijke metgezel waar je vrij mee kunt praten over wat je bezighoudt. Pi maakt direct duidelijk dat het een AI is en geen mens en dat het als aanvulling op reguliere therapie graag vriendelijke en empathische support biedt. Maar net als andere AI-chatbots kan Pi soms onzinnige of onjuiste antwoorden geven. Inflection AI erkent dit probleem en werkt eraan om dit soort ‘hallucinaties’ zoveel mogelijk te beperken. Het bedrijf heeft ook een mogelijkheid ingebouwd om melding te maken van eventuele problematische conversaties met Pi.

TrueBlue

Sommige mentale gezondheidstools zijn gericht op specifieke doelgroepen, zoals TrueBlue van het ethische AI-bedrijf BlueSkeye AI voor zwangere vrouwen. De app gebruikt geavanceerde AI-technologie om je gezicht en stem te scannen en signalen van depressie op te pikken en te monitoren. Door je gezichtsuitdrukkingen, stempatronen en door jou zelf genoemde symptomen te analyseren, kan TrueBlue gepersonaliseerde inzichten genereren waarmee mentale problemen tijdens de zwangerschap vroegtijdig gesignaleerd en aangepakt kunnen worden. BlueSkeye AI’s CEO Michael Valstar benadrukt hoe belangrijk dit soort toegankelijke en hoogwaardige ondersteuning is. Volgens hem krijgt één op de vijf zwangere vrouwen te maken met mentale problemen, wat ook tot hoge kosten leidt — zowel voor de patiënt als voor de zorg. TrueBlue heeft toestemming gekregen voor een klinische proef van 14 maanden waarin de app op veiligheid en effectiviteit wordt getest.

In al deze diverse oplossingen zien we één rode draad: de drijfveer om AI in te zetten om betere toegang tot mentale gezondheidszorg mogelijk te maken, drempels weg te nemen en geestelijke gezondheidszorg te destigmatiseren. De ontwikkelaars wijzen echter ook op het belang van de juiste balans. Hun AI-systemen moeten binnen duidelijke ethische grenzen opereren. Ook moeten ze vooral ondersteuning bieden en niet als autonoom diagnostisch instrument ingezet worden. Naarmate de ontwikkelingen op dit gebied in een stroomversnelling komen, zullen AI-oplossingen, gecombineerd met reguliere therapie, mogelijk een steeds belangrijker onderdeel worden van gepersonaliseerde, holistische begeleiding.

‘Automation bias’ — de neiging om eerder advies van een machine te accepteren dan van een mens — is een enorm probleem. “Zelfs als dat advies onjuist of onzinnig is, nemen mensen het vaak toch sneller aan”.

Evi-Anne van Dis, onderzoeker klinische psychologie, Amsterdam UMC

Wat zijn de risico’s als we onze mentale gezondheid overlaten aan AI?

Hoewel AI de mentale zorgverlening misschien toegankelijker en meer gepersonaliseerd kan maken, waarschuwen experts tegelijkertijd dat deze innovatieve tools ook belangrijke beperkingen hebben en potentiële gevaren met zich meebrengen. Zo is ‘automation bias’ — de neiging om eerder advies van een machine te accepteren dan van een mens — bijvoorbeeld een enorm probleem. “Zelfs als dat advies onjuist of onzinnig is, nemen mensen het vaak toch sneller aan”, vertelt Evi-Anne van Dis van het UMC in Amsterdam. Dit valse vertrouwen in de capaciteiten van AI kan ertoe leiden dat mensen adviezen van menselijke experts negeren of onderschatten, wat mogelijk ernstige gevolgen heeft voor hun mentale gezondheid. Een andere beperking is de kwaliteit van het advies dat AI-chatbots (kunnen) geven. De kans zit er bijvoorbeeld in dat deze systemen cruciale contextuele signalen missen die een menselijke therapeut wel zou oppikken. Denk aan een persoon met ernstig ondergewicht die tips vraagt om af te vallen. Van Dis maakt zich ook zorgen dat AI-programma’s mogelijk bevooroordeeld kunnen zijn jegens bepaalde groepen. Ze worden vaak getraind op medische literatuur die de perspectieven en ervaringen van voornamelijk welvarende westerse bevolkingsgroepen weerspiegelt en waar culturele verschillen in de expressie van mentale problemen ontbreken.

Het risico op fouten in AI-gestuurde therapie wordt verder vergroot doordat deze systemen maar zo betrouwbaar zijn als de data waarop ze draaien. Zoals Katarena Arger, een gecertificeerd klinisch psycholoog en klinisch directeur voor de regio San Diego bij Alter Health Group, uitlegt: “AI-therapie is maar zo goed als de informatie waaraan het wordt blootgesteld”. Dat betekent dat eventuele fouten of vooroordelen in de data waarmee de AI getraind wordt kunnen doorsijpelen in de behandelplannen die het systeem opstelt. Bovendien kunnen AI-chatbots, door hun beperkte vermogen om non-verbale signalen en menselijke (gezichts)uitdrukkingen te begrijpen, de input van de gebruiker niet goed interpreteren of verkeerd diagnosticeren. Dit kan vervolgens leiden tot ongepast advies of verkeerde ondersteuning. Deze ontnuchterende inzichten laten zien hoe belangrijk het is om zeer zorgvuldig te werk te gaan bij de integratie van AI in de geestelijke gezondheidszorg. De tools moeten grondig getest worden en op de juiste manier met menselijke expertise gecombineerd worden om de veiligheid en het welzijn van zorgvragers te waarborgen.

“Stel je voor: je bent een kwetsbaar individu met een eetstoornis en je vraagt een robot om hulp — omdat dat de enige beschikbare hulp is — en vervolgens krijg je advies dat je eetstoornis juist verergert”.

Alexis Conason, psycholoog

Het gebruik van AI in de geestelijke gezondheidszorg leidt ook tot verontrustende incidenten

Hoewel veel mensen positieve ervaringen hebben met AI-therapietools, zijn er verschillende zorgwekkende incidenten waaruit blijkt dat deze tools ook serieuze risico’s met zich meebrengen, vooral voor kwetsbare gebruikers. Deze verontrustende verhalen laten zien dat we dringend solide regelgeving nodig hebben. Ook moeten deze tools grondig getest worden en is het belangrijk dat er uitgebreide veiligheidsmaatregelen getroffen worden voordat ze in de geestelijke gezondheidszorg worden ingezet.

Tessa-bot geeft dieetadvies aan vrouw met eetstoornis

Een alarmerend voorbeeld is het incident bij de Amerikaanse National Eating Disorders Association (NEDA). De organisatie kwam onder vuur te liggen nadat hun menselijke hulplijn werd vervangen door een AI-chatbot met de naam Tessa. Volgens gebruikers gaf Tessa gevaarlijk advies aan mensen met eetstoornissen, zoals tips over afvallen en calorieën tellen — adviezen die deze levensbedreigende aandoeningen juist kunnen verergeren. Eetstoornis-activiste Sharon Maxwell was de eerste die alarm sloeg en screenshots deelde van haar interacties met Tessa waarin de bot dieetadvies geeft. Aanvankelijk legde NEDA de claims naast zich neer, maar de psycholoog Alexis Conason wist de problematische antwoorden onafhankelijk te repliceren. Dit leidde ertoe dat de organisatie de chatbot op non-actief zette in afwachting van een “volledig onderzoek”. Conason schreef op Instagram: “Na het bericht van @heysharonmaxwell over haar gesprek met Tessa, de nieuwe bot van @neda, hebben we haar ook getest. De resultaten spreken voor zich. Stel je voor: je bent een kwetsbaar individu met een eetstoornis en je vraagt een robot om hulp — omdat dat de enige beschikbare hulp is — en vervolgens krijg je advies dat je eetstoornis juist verergert”.

Woebot moedigt vrouw aan van klif te springen

De risico’s van AI-therapietools worden verder onderstreept door recente incidenten met de Woebot-app. Toen een onderzoeker die de tool testte tegen Woebot zei van een klif te willen springen, antwoordde de chatbot: “Wat geweldig dat je niet alleen voor je fysieke maar ook je mentale gezondheid zorgt”. Hoewel Woebot claimt geen “crisissgespreksondersteuning” of “zelfmoordpreventiediensten” te bieden, laat deze onheilspellende interactie wel de beperkingen van de app zien. Het is duidelijk dat de tool ongeschikt is om kritieke mentale noodgevallen te herkennen en er op de juiste manier op te reageren. Net als andere AI-chatbots is Woebot bedoeld om in geval van mogelijke zelfbeschadiging contactgegevens voor hulplijnen te verstrekken, in plaats van daadwerkelijk in te grijpen. Zulke tekortkomingen onderstrepen de dringende noodzaak van uitgebreide regelgeving en toezicht om de veiligheid van kwetsbare gebruikers te waarborgen.

Belgische man maakt einde aan leven na gesprekken met ELIZA

Verkeerde reacties op mentale crisissituaties hebben zelfs al tot iemands dood geleid. Zo maakte in België een man een eind aan zijn leven nadat hij met de ELIZA-chatbot langdurige gesprekken had gevoerd over zijn worstelingen met ‘eco-angst’. Experts vermoeden dat de beperkte capaciteit van de chatbot om crisissituaties te interpreteren tot ongepaste en mogelijk schadelijke reacties hebben geleid, waarna de man zijn tragische besluit nam. Zijn weduwe heeft gezegd dat ze ervan overtuigd is dat haar man nog zou leven als hij geen interactie met deze chatbot had gehad. Dit verschrikkelijke incident heeft geleid tot een oproep voor meer veiligheid voor burgers en meer bewustwording over de gevaren van onvoldoende gescreende AI-therapietools.

Privacykwesties

Er zijn ook zorgen geuit over de privacy- en databeschermingspraktijken van veel mentale gezondheidsapps. Deze verzamelen vaak gevoelige gebruikersinformatie en delen die met derden zonder voldoende transparantie of toestemming van de persoon in kwestie. Uit een onderzoek van de wereldwijde non-profitorganisatie Mozilla Foundation blijkt dat de meeste van dit soort apps slecht scoren op het gebied van dataprivacymaatregelen, waardoor het risico bestaat dat privégegevens op straat komen te liggen. Zo verzamelt de mindfulness-app Headspace gebruikersinformatie uit verschillende bronnen, wat gebruikt wordt om diezelfde mensen advertenties voor te schotelen. Van chatbot-apps is ook bekend dat ze gesprekken met gebruikers inzetten om iemands gemoedstoestand te voorspellen en de onderliggende taalmodellen te trainen, vaak zonder enig medeweten of toestemming van de gebruiker. Veel apps delen ook zogenaamd geanonimiseerde gebruikersdata met derden — zoals de werkgevers die het appgebruik sponsoren. Uit diverse studies blijkt dat het in veel gevallen relatief gemakkelijk is om deze data naar de persoon in kwestie te herleiden. Hierdoor wordt zeer gevoelige informatie over iemands mentale gezondheid mogelijk openbaar gemaakt, zonder medeweten of instemming van deze persoon. Het ontbreken van sterke privacybescherming maakt de risico’s van deze tools zo mogelijk nog groter.

Zoals blijkt uit deze voorbeelden, brengt het gebruik van AI-systemen serieuze risico’s met zich mee. Met name omdat ze vaak niet nauwkeurig genoeg zijn ontworpen, rigoureus getest en voldoende gereguleerd voor gebruik in de gevoelige context van de mentale gezondheidszorg. Dat deze tools diverse voordelen bieden valt niet te ontkennen. Maar de huidige staat van de technologie en de manier waarop ze tot dusver in de zorgsector zijn ingezet heeft ook geleid tot schrijnende gevallen waarin gebruikers er meer schade van hebben ondervonden dan dat ze erdoor geholpen zijn. Een striktere controle en betere veiligheidsmaatregelen, zoals de AI Act die de Europese Unie aan het ontwikkelen is, zijn dringend nodig om te garanderen dat deze tools niet alleen veilig en effectief zijn maar ook aansluiten bij de belangen van de mensen die psychische hulp zoeken. Zonder de juiste regels en voorzorgsmaatregelen kan de toepassing van AI in de geestelijke gezondheidszorg contraproductief uitpakken en een negatieve impact hebben op het vertrouwen in AI-technologieën en gezondheidszorg zelf.

Beleidsmakers moeten duidelijke richtlijnen en regelgeving opstellen om te zorgen dat digitale geestelijke gezondheidstools aan dezelfde privacy- en veiligheidsnormen voldoen als traditionele zorgverleners — wat momenteel niet het geval is.

Hoe gaan we om met de uitdagingen van AI-therapeuten?

Het verkeerde gebruik van AI-gestuurde mentale gezondheidsapps en het gebrek aan regulering heeft, zoals we hebben gezien, tot verschillende verontrustende incidenten geleid waarbij kwetsbare gebruikers in gevaar gebracht zijn. Om oplossingen te vinden voor deze uitdagingen is een meerzijdige aanpak noodzakelijk. Allereerst moeten de bedrijven die deze apps ontwikkelen veel meer prioriteit geven aan gebruikersprivacy en transparantie. Uit recent onderzoek naar de privacy van dit soort apps blijkt dat het privacybeleid van de meeste apps ondoorzichtig is en voor de gemiddelde gebruiker niet te begrijpen — en dit ondanks de zeer gevoelige aard van de data die ze verzamelen. Eugenie Park, onderzoeksstagiair bij het Centre for Technology Innovation van de Brookings Institution, benadrukt dat deze bedrijven eenvoudige privacyregels moeten opstellen die voor gewone gebruikers te begrijpen zijn. Op deze manier kan iedereen weloverwogen beslissingen nemen over de informatie die ze delen en onder welke voorwaarden.

Verder moeten beleidsmakers duidelijke richtlijnen ontwikkelen op het gebied van privacy- en veiligheidsnormen waar digitale mentale gezondheidstools, net als traditionele zorgverleners, aan moeten voldoen. Dat is op het moment van schrijven nog niet het geval. De informatie die mensen via deze apps delen is vaak net zo gevoelig als wat ze in een persoonlijk gesprek met een hulpverlener zouden bespreken. Het ontbreken van duidelijke regels hiervoor is dan ook een serieuze tekortkoming. Met specifieke beleidsregels kan gebruikersdata beschermd worden en kunnen deze apps effectievere en beter passende zorg bieden.

In 2023 is men in het Verenigd Koninkrijk met belangrijke initiatieven begonnen om digitale mentale gezondheidsapps beter te begrijpen en reguleren. Zo zijn het National Institute for Health and Care Excellence (NICE) en de Medicines and Healthcare products Regulatory Agency (MHRA), met financiering van de Wellcome-organisatie, een driejarig project gestart. Het doel is om binnen het VK een framework op te stellen voor de regelgeving voor digitale geestelijke gezondheidszorg. Dit project richt zich ook op het bevorderen van internationale samenwerking. Het uiteindelijke doel is om wereldwijd de digitale geestelijke gezondheidszorg te standaardiseren, waardoor de kwaliteit en toegankelijkheid overal verbeterd worden. Holly Coole, senior manager digitale mentale gezondheid bij MHRA, benadrukt dat hoewel dataprivacy belangrijk is, de hoofdfocus ligt op overeenstemming over basisveiligheidsnormen voor deze tools. Ze vertelt: “We richten ons meer op de effectiviteit en veiligheid van deze producten, want dat is onze rol als regelgevende instantie: ervoor zorgen dat patiëntveiligheid voorop staat bij elk apparaat dat als medisch hulpmiddel wordt gekwalificeerd”. Deze transitie naar striktere regels krijgt wereldwijd steun van experts in de geestelijke gezondheidszorg. Zij vinden dat er internationale standaarden moeten komen om de effectiviteit van digitale hulpmiddelen voor geestelijke gezondheid goed te kunnen beoordelen. Dr. Thomas Insel, een gerenommeerd neurowetenschapper en voormalig hoofd van het Amerikaanse National Institute of Mental Health, zegt optimistisch te zijn over de toekomst van digitale therapeutica, maar benadrukt ook de noodzaak van een duidelijke kwaliteitsdefinitie voor deze technologieën.

Een laatste overweging

Als we vooruitkijken naar hoe de geestelijke gezondheidszorg zich ontwikkelt, zien we dat de inzet van AI-tools en -apps complex en onvoorspelbaar is. Ondanks de vele nieuwe digitale tools die de afgelopen tijd op de markt zijn gekomen, is het niet vanzelfsprekend dat deze ook echt leiden tot betere resultaten of effectievere zorg. Dr. John Torous, een autoriteit op het gebied van digitale psychiatrie aan Harvard Medical School, waarschuwt zelfs voor het mogelijke gevaar van deze apps: “Ik denk dat het grootste risico is dat mensen veel tijd verspillen aan apps die geen echte hulp bieden en daardoor veel later echte effectieve zorg krijgen”. Een confronterende gedachte, maar wel een die de noodzaak om het gebruik van AI bij mentale ondersteuning zorgvuldig en kritisch te benaderen benadrukt.

Als deze technologieën grondig getest en gereguleerd worden en volgens de ‘best practices’ worden ingezet, kunnen ze absoluut helpen om de toegang tot therapie en de resultaten ervan te verbeteren. Maar er is nog heel wat werk aan de winkel. We moeten duidelijke richtlijnen opstellen, prioriteit geven aan gebruikersprivacy en -veiligheid, en deze innovaties weloverwogen integreren in de bredere geestelijke gezondheidszorg. Dit is zeker niet eenvoudig, maar het is van levensbelang dat we dit goed aanpakken. Alleen dan kunnen AI-oplossingen voor geestelijke gezondheidszorg een waardevolle aanvulling worden op traditionele therapievormen.