- Samenvatting

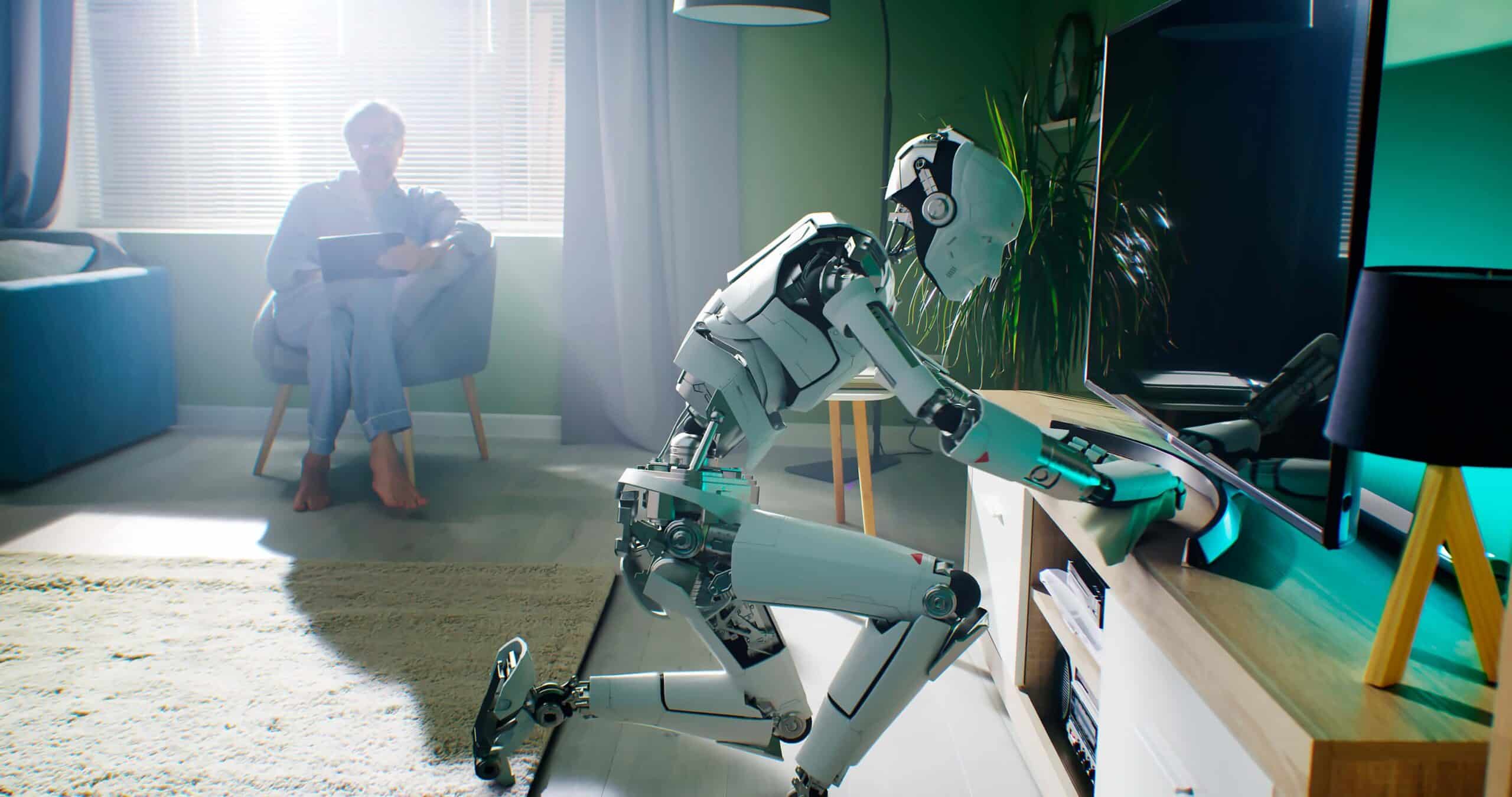

- Introductie

- De kracht van virtuele training voor robots

- De ‘digitale speeltuin’ van Google DeepMind

- Waarom kijkt mijn robot naar YouTube?

- CMU’s video leersuite

- Het sturen van robots naar succes

- Toyota leert robots via teleoperation

- Gedraag je als een mens en vouw je was

- UC Berkeley’s ‘SpeedFolding’ robot

- Getraind voor een aanpak van de toekomst

- Geleerde lessen

Samenvatting

De groeiende complexiteit van de taken die we aan robots geven, betekent dat we binnenkort misschien niet meer kunnen vertrouwen op robots met rigide, regel gebaseerde programmering. In plaats daarvan kan een verschuiving naar observationeel leren nodig zijn om nieuwe vaardigheden bij te brengen. Hoewel zo’n ontwikkeling tien jaar geleden misschien ondenkbaar was, zetten nu allerlei organisaties grote stappen om dit realiteit te maken.

- Google DeepMind heeft een virtuele speeltuin opgezet waarin het AI traint.

- CMU gebruikt leren via video’s om robots praktische demonstraties te geven over hoe ze taken moeten uitvoeren.

- Toyota neemt letterlijk de controle over de robot over, bekend als ’teleoperatie’, om deze door zijn taken heen te loodsen.

- De robot van UC Berkeley kan de fijne motoriek van een mens imiteren, zodat hij wasgoed kan vouwen met verbazingwekkende snelheid.

- De massale inzet van robots kan leiden tot lastige vragen over de rol van de mens, waarop geen makkelijk antwoord te geven is.

De robotica maakt enorme sprongen voorwaarts en waarschijnlijk moeten we overstappen op observationeel leren om droids te trainen voor de taken die we van ze verwachten in de maatschappij. Het zal niet makkelijk zijn om deze weg te volgen, maar als we ons enthousiasme met enige voorzichtigheid benaderen, is een toekomst waarin geavanceerde robotica iedereen ten goede komt nog steeds mogelijk.

Introductie

Er kan een nieuw tijdperk aanbreken op het gebied van robotica, waarin robots niet leren door code maar door imitatie. Deze sprong voorwaarts wordt mogelijk gemaakt door generatieve AI, een technologie die machines in staat stelt complexe menselijke gedragingen te observeren en na te bootsen. Deze robots kunnen nu real-time vaardigheden krijgen door acties te analyseren en imiteren die ze zien in de fysieke wereld of via digitale media zoals video’s. Van eenvoudige gebaren tot complexe patronen, alles is mogelijk voor het algoritme.

De overstap van op regels gebaseerde menselijke instructies naar observationeel leren opent een groot aantal mogelijkheden. Over tien jaar zouden er robots kunnen zijn die in de gezondheidszorg rechtstreeks van chirurgen leren om te assisteren bij operaties, of die in kunststudio’s studenten de basisprincipes van schildertechnieken bijbrengen. In welke sector je ook kijkt, de toepassingen lijken oneindig.

Aan de basis van deze revolutie ligt reinforcement learning, een proces waarbij robots hun vaardigheden verfijnen door vallen en opstaan. Het verschilt eigenlijk niet zoveel van wat mensen doen bij het aanleren van een nieuwe vaardigheid. Door generatieve AI te combineren met deze aanpak, zouden we echter robots kunnen zien die in staat zijn sneller te leren dan een mens en met een aanzienlijk hoger vaardigheidsniveau. In dit artikel gaan we naar de koplopers van deze technologie en hoe deze vandaag de dag wordt ingezet. We kijken ook naar de toekomst en overwegen hoe autonoom leren de antwoorden kan bieden op de grootste uitdagingen van morgen.

De kracht van virtuele training voor robots

Wat is de veiligste manier om een robot te leren hoe hij zijn taken moet uitvoeren? Waarschijnlijk in een gesimuleerde omgeving.

Wat heeft een robot nodig om succesvol menselijk gedrag na te bootsen? Nou, het begint allemaal met data – heel veel data. Meestal krijgen robots eerst enorme hoeveelheden informatie over menselijke acties en reacties in een breed scala aan contexten. Deze gegevens worden vervolgens verwerkt met behulp van deep learning algoritmen om relevante patronen en kenmerken over te nemen. Door herhaaldelijk te trainen, kan het neurale netwerk van de robot geleidelijk zijn begrip van menselijk gedrag verbeteren, waardoor het in staat is om steeds nauwkeurigere en natuurlijker ogende reacties te produceren.

Echte imitatie vereist echter meer dan alleen eenvoudige patroonherkenning. Robots moeten zich ook kunnen aanpassen en improviseren wanneer ze geconfronteerd worden met situaties die niet specifiek in hun programmering zijn opgenomen. Met andere woorden, ze moeten dezelfde flexibiliteit en creativiteit tonen die ons mensen van nature eigen is. ‘Is dit überhaupt mogelijk?’, vraag je je misschien af. Hoewel we er misschien nog niet helemaal zijn, komen we steeds dichter bij het realiseren van dit doel.

De ‘digitale speeltuin’ van Google DeepMind

Google DeepMind is een van de meest opmerkelijke spelers op dit gebied en zet een precedent voor nieuwe vormen van menselijke imitatie via zijn digitale speeltuin GoalCycle3D. In deze virtuele omgeving kan een AI zijn vaardigheden perfectioneren door herhaaldelijk te proberen en te leren van fouten. In tegenstelling tot conventionele AI’s die uitgebreide training met ontelbare voorbeelden nodig hebben om een eenvoudige taak uit te voeren, leert DeepMind’s nieuwste creatie in real-time door simpelweg menselijke demonstrateurs te observeren. Het is een techniek die doet denken aan een van onze meest complexe vermogens – het vermogen om snel van elkaar te leren, een vaardigheid die van essentieel belang is geweest voor de ontwikkeling van de mens.

In GoalCycle3D moet de AI interactie aangaan met een voortdurend veranderend landschap vol hindernissen die overwonnen moeten worden. Hier leren AI niet door eentonige herhaling, maar door een expert – gecodeerd of door mensen bestuurd – snel door het parcours te zien navigeren. Door dit te doen, begrijpen ze de nuances van de taak, waarbij ze hun vaardigheden verfijnen door pure observatie. Na hun training blijken de AI’s in staat om de acties van de expert zelfstandig na te bootsen: een duidelijke indicatie dat ze niet alleen combinaties uit het hoofd leren, maar de taken echt begrijpen. De onderzoekers hebben de AI uitgerust met een voorspellende focus en een geheugenmodule om dit mogelijk te maken.

Hoewel dit veelbelovende ontwikkelingen zijn, is het vertalen van deze technologie van virtuele omgevingen naar real-life situaties niet eenvoudig. Het leren van de AI werd getest onder begeleiding van een consistente menselijke gids tijdens de proeven, wat de vraag oproept: kan het zich aanpassen aan onvoorspelbare en diverse menselijke instructies? Bovendien is de dynamische en willekeurige aard van de trainingsomgeving in GoalCycle3D moeilijk te repliceren in de minder voorspelbare echte wereld. Om nog maar te zwijgen van het feit dat de taken relatief eenvoudig waren en niet de fijne motorische vaardigheden vereisten die veel taken in de echte wereld vragen.

Toch is de vooruitgang in sociaal leren door AI een belangrijke innovatie. De AI van DeepMind, met zijn nieuwe leermogelijkheden, biedt een interessante blik op een toekomst waarin machines rechtstreeks kunnen leren zonder input van een team van programmeurs. Het is een evenwichtsoefening tussen de strikte, formele eisen van AI-ontwikkeling en het informele, adaptieve leren dat typisch is voor menselijke intelligentie. DeepMind beweegt zich op dit gebied met veelbelovende precisie.

“De robot kan leren waar en hoe mensen omgaan met verschillende objecten door het bekijken van video’s. Met deze kennis kunnen we een model trainen waarmee twee robots vergelijkbare taken kunnen uitvoeren in verschillende omgevingen”.

Deepak Pathak, universitair docent aan CMU

Waarom kijkt mijn robot naar YouTube?

Video-instructie kan een verrassend effectieve methode blijken om robots te leren hoe ze dingen moeten doen.

Laten we eerlijk zijn: hoewel er een miljoen baanbrekende toepassingen voor robots zijn, willen de meesten van ons gewoon iets dat kan helpen in huis. Stel je voor dat je een robot hebt die door je huis kan navigeren, je afwas kan doen, je bed kan opmaken en zelfs kan koken. Het is de ultieme droom voor iedereen die zich ooit overweldigd heeft gevoeld door de eindeloze lijst met klusjes en taken die horen bij het runnen van een huishouden.

Het creëren van een robot die in staat is om te navigeren in de onvoorspelbare omgeving van ons huis is geen eenvoudige taak en ruwe rekenkracht gaat alleen niet volstaan. Het uitrusten van de robot met geavanceerde sensoren die het in staat stellen zijn omgeving waar te nemen en obstakels te vermijden die op zijn pad verschijnen, is relatief eenvoudig, hoewel mogelijk erg duur.

Mensen hebben het tegenwoordig makkelijk. Met de overvloed aan online video-inhoud is er voor vrijwel elke taak die we kunnen bedenken een stapsgewijze handleiding – hoe niche of obscuur die taak ook is. Maar wat als er een manier was om deze video-inhoud in te zetten voor de training van robots?

CMU’s video leersuite

Het blijkt dat een team onderzoekers van de Carnegie Mellon University (CMU) hiermee bezig is. Ze leren robots allerlei huishoudelijke taken uit te voeren – niet door zelf het voorbeeld te geven, maar via video-demonstraties. Dit is een significante sprong voorwaarts ten opzichte van meer gestandaardiseerde methoden die vooraf arbeidsintensieve, op regels gebaseerde codering vereisen. Door gebruik te maken van grote datasets zoals Ego4D, met letterlijk duizenden uren aan first-person beelden, en Epic Kitchens, die keukenactiviteiten vastlegt, traint het team van CMU zijn robots om te leren van een divers scala aan menselijk gedrag.

Deze datasets, die voorheen bedoeld waren voor het trainen van computer vision modellen, blijken essentieel te zijn om robots te leren van internet en YouTube-video’s. “De robot kan leren waar en hoe mensen omgaan met verschillende objecten door het bekijken van video’s. Met deze kennis kunnen we een model trainen waarmee twee robots vergelijkbare taken kunnen uitvoeren in verschillende omgevingen”, legt Deepak Pathak, universitair docent aan CMU, uit. Het team van Pathak is verder gegaan dan hun eerdere werk, bekend als In-the-Wild Human Imitating Robot Learning (WHIRL), dat menselijke demonstraties in de aanwezigheid van de robot vereiste. Hun nieuwe model, de Vision-Robotics Bridge (VRB), stroomlijnt dit proces en maakt directe menselijke begeleiding en identieke omgevingen overbodig.

Nu kan een robot een nieuwe taak oppakken in slechts 25 minuten oefenen. Shikhar Bahl, een promovendus in de robotica, deelt het enthousiasme van het team: “We konden robots over de campus laten rondlopen en allerlei taken laten uitvoeren. Robots kunnen dit model gebruiken om met een nieuwsgierige blik de wereld om hen heen te verkennen”. Deze nieuwsgierigheid wordt gestuurd door een geavanceerd begrip van ‘affordances’ – een term geleend uit de psychologie, die de potentiële acties aangeeft die een individu in zijn omgeving ter beschikking staan. Door contactpunten en bewegingen te identificeren, zoals een mens die een lade opent, kan een robot afleiden hoe hij deze actie op elke lade kan uitvoeren.

Hoewel het werk op het gebied van video-leren in een hoog tempo doorgaat, is het belangrijk om te onthouden dat dit werk niet simpelweg gaat over het leren van een robot hoe hij de afwas moet doen. Het gaat er eerder om hun potentieel te ontsluiten om autonoom te leren van de overvloed aan online video content. Zorg er alleen voor dat de filter voor expliciete inhoud aan blijft staan.

Het sturen van robots naar succes

Verplaats jezelf in de schoenen van de robot – letterlijk – en leid hem door de juiste manier om een taak uit te voeren.

Heb je ooit geprobeerd een nieuwe vaardigheid onder de knie te krijgen en merkte je dat je worstelde, waarna een leidinggevende ingreep en je erdoorheen leidde? Het is een van de meest effectieve manieren om iemands ongerustheid over het leerproces weg te nemen, maar het is ook briljant nuttig voor praktische demonstraties. Denk je echter dat je hetzelfde zou voelen als de leidinggevende de controle over je hele lichaam overnam om je te laten zien wat je moet doen?

Nou, het zou je misschien afschrikken, maar dit is precies hoe de robotica-onderzoekers in ons volgende voorbeeld robots leren hun taken uit te voeren. Deze praktische aanpak maakt een intuïtievere en efficiëntere overdracht van kennis mogelijk, waardoor robots vaardigheden kunnen leren die anders moeilijk te leren zijn via traditionele programmeermethoden.

“Deze nieuwe onderwijstechniek is zowel zeer efficiënt als levert gedragingen met zeer hoge prestaties op, waardoor robots mensen op vele manieren veel effectiever kunnen versterken”.

Gill Pratt, chief executive officer van TRI

Toyota leert robots via teleoperation

Het Toyota Research Institute (TRI) heeft een technologie ontwikkeld genaamd Diffusion Policy, waarmee robots snel complexe taken kunnen leren, zoals pannenkoeken omdraaien en groenten schillen. Zo werkt het: een mens bestuurt de robot op afstand en geeft verschillende demonstraties om van te leren. De robot verwerkt deze informatie vervolgens zelfstandig en past zijn nieuwe vaardigheden toe op taken zonder verdere menselijke tussenkomst.

De Diffusion Policy-techniek heeft robots bij TRI al in staat gesteld om meer dan 60 verschillende vaardigheden te beheersen, van het manipuleren van vervormbare materialen tot het gieten van vloeistoffen. En dat allemaal zonder nieuwe code te hoeven schrijven – gewoon door de robots nieuwe demonstratiegegevens te geven. De aanpak maakt gebruik van dezelfde diffusieprocessen die worden gebruikt bij geavanceerde beeldgeneratie, en profiteert van voordelen zoals aanpasbaarheid aan multimodale demonstraties, het vermogen om hoogdimensionale acties in de tijd te plannen en stabiliteit in training zonder de noodzaak van constante aanpassingen in de echte wereld. Russ Tedrake, vice-president Robotica bij TRI, merkte op dat hun robots nu taken uitvoeren die “gewoon verbazingwekkend” zijn en een jaar geleden nog onbereikbaar waren.

Dat gezegd hebbende, blijft Diffusion Policy een voortdurende ontwikkeling. De robots falen soms inderdaad bij het toepassen van hun vaardigheden buiten een gecontroleerde omgeving. TRI erkent deze uitdagingen en heeft zijn visie verbreed om plaats te bieden aan een ‘groot gedragsmodel’ dat parallel loopt met de geavanceerdheid van grote taalmodellen in het begrijpen en genereren van geschreven content. Met het ambitieuze doel om robots tegen 2024 duizend vaardigheden te leren, baant TRI een weg naar een toekomst waarin robots met een rijk assortiment aan bewegingen naadloos samenwerken met mensen.

Gedraag je als een mens en vouw je was

Leer een robot de was vouwen en je hoeft het nooit meer zelf te doen.

Inmiddels zul je misschien een terugkerend thema hebben opgemerkt: iedereen wil dat robots hun klusjes doen. Soms kan het lijken alsof het uiteindelijke doel van elke roboticus op aarde simpelweg is om nooit meer hun eigen was te hoeven vouwen. Als je dacht dat dit volgende voorbeeld je van het tegendeel zou bewijzen, dan heb je het mooi fout.

Er is echter meer aan de hand dan alleen luiheid of een verlangen naar meer gemak. Een robot die je klusjes voor je kan doen, zou de levenskwaliteit aanzienlijk verbeteren voor miljoenen mensen over de hele wereld die worstelen met fysieke beperkingen of handicaps. Is dat niet iets om naar te streven? Het vouwen van was vereist echter een verrassend hoog niveau van behendigheid, waar onderzoekers zich momenteel op richten.

UC Berkeley’s ‘SpeedFolding’ robot

Aan de UC Berkeley voltrekt zich een revolutie in de wasruimte. Het Autolab van de universiteit heeft ‘SpeedFolding’ onthuld, een methodologie die robots traint om de was te vouwen. In een wereld waar wasmachines en drogers al lang het zwoegen uit de wasdag hebben gehaald, is het vouwen als laatste obstakel hardnekkig handmatig gebleven. SpeedFolding wil deze taak naar de geschiedenisboeken verwijzen en pronkt met een recordbrekende snelheid van 30-40 kledingstukken per uur, een indrukwekkende stijging ten opzichte van de vorige maatstaf van slechts 3-6 vouwsels.

Het punt is dat de was vouwen niet zo eenvoudig is als het lijkt. De diversiteit aan vormen en materialen van kleding, van dun en glibberig tot gevoelig voor statische aantrekking, maakt het een ideale kandidaat om robots te trainen in complexe taken. De aanpak van UC Berkeley heeft deze hindernissen overwonnen met een systeem dat het menselijke vouwproces nabootst – het analyseert meer dan 4.300 acties om de vorm van wasgoed uit een verkreukelde hoop te voorspellen, ze glad te strijken en vervolgens langs precieze lijnen te vouwen.

Centraal in deze innovatie staat het BiManual Manipulation Network (BiMaMa), een neuraal netwerk dat twee robotarmen aanstuurt in een gecoördineerd samenspel van complexe bewegingen. Het tweearmige systeem imiteert de coördinatie die in menselijke ledematen wordt aangetroffen, waardoor kledingstukken efficiënt kunnen worden gladgestreken en gevouwen in geordende stapels. Het slagingspercentage? Een indrukwekkende 93%, waarbij de meeste stukken in minder dan twee minuten netjes zijn gevouwen. Hoewel dit systeem niet is vergeleken met het vouwvermogen van de gemiddelde tiener, zijn de efficiëntie en nauwkeurigheid ongetwijfeld superieur. Naarmate UC Berkeley deze methodologie blijft verfijnen, komt de dag dat robots naadloos integreren in onze huizen om te helpen met dagelijkse taken steeds dichterbij.

Getraind voor een aanpak van de toekomst

Robots kunnen mensen op ontelbare manieren helpen. Maar zouden ze ons op een dag kunnen vervangen?

Op dit punt zou er weinig twijfel moeten bestaan over hoe robots ons huiselijk leven zullen transformeren. Het punt is dat de was vouwen een onbeduidende kwestie is vergeleken met enkele van de grotere uitdagingen waarbij deze door AI aangestuurde robots ons zouden kunnen helpen. In een wereld die geteisterd wordt door de opwarming van de aarde, zouden robots de plaats kunnen innemen van menselijke hulpverleners bij noodgevallen en levens kunnen redden in situaties die anders dodelijk zouden kunnen zijn. Ze zouden zelfs in de ruimte kunnen worden ingezet naast astronauten om te helpen bij moeilijke samenwerkingstaken of om reparaties uit te voeren die mogelijk mensenlevens in gevaar zouden kunnen brengen. De Boston Consulting Group voorspelde in 2021 dat de markt voor geavanceerde robotica een enorme waardesprong zal maken, van een basislijn van 26 miljard dollar naar maar liefst 250 miljard dollar tegen het einde van het decennium.

Het is echter essentieel om in gedachten te houden dat, hoewel deze robots ons effectief kunnen nabootsen, ze ons nooit kunnen vervangen. Dit kan niet genegeerd worden: McKinsey heeft voorspeld dat tegen 2050 maar liefst 50% van alle menselijke banen verloren zal gaan aan robots en automatisering. Mensen hebben een doel nodig en niet iedereen die door de opkomst van robots wordt verdrongen, zal zich comfortabel voelen bij de overgang naar een leven als zorgeloze kunstenaar. Wat het betekent voor de werkgelegenheid in sectoren die van oudsher afhankelijk zijn van menselijke arbeid, blijft een onbeantwoorde vraag. Hoe zorgen we ervoor dat ethische overwegingen dezelfde trend houden met de robotica, vooral met betrekking tot onze privacy en autonomie? Deze vraag is niet retorisch, maar een essentieel controlepunt op onze ontwikkeling voorwaarts.

Geleerde lessen

De snelheid van technologische ontwikkelingen in de robotica neemt in een steeds hoger tempo toe en het lijkt erop dat onze keukens en washokken als eerste zullen worden beïnvloed. De implicaties van deze ontwikkelingen gaan veel verder dan louter gemak; ze nodigen ons uit om onze relatie met machines te heroverwegen en, misschien nog belangrijker, onze opvattingen over onszelf.

- Er is nog geen gestandaardiseerde methode voor observationeel leren bij robots vastgesteld.

- De drie meest veelbelovende benaderingen zijn leren in een virtuele omgeving, video tutorials en teleoperation.

- Robots zijn in toenemende mate in staat om taken uit te voeren die fijne motoriek vereisen, wat ooit een uiterst moeilijke taak was om te volbrengen.

- BCG voorspelt dat de markt voor geavanceerde robotica tegen 2030 met een factor tien zou kunnen groeien tot een waarde van 250 miljard dollar.

- Tegen 2050 zou de helft van alle menselijke banen overbodig kunnen worden, wat een zorgvuldige afweging vereist van hoe we robots in de samenleving integreren.

Het spreekt voor zich dat de potentiële voordelen verleidelijk zijn. Dat gezegd hebbende, gaat het niet alleen om wat machines voor ons kunnen doen, maar ook om wat dit betekent voor de toekomst van het menselijk potentieel. Om een rechtvaardige toekomst voor iedereen te garanderen, moeten we zorgvuldig nadenken over het soort wereld dat we met deze geavanceerde robots willen creëren.